Buenos días, gente, hoy vamos con un post que habla del Googlebot, el rastreador de Google que indexa los sitios web para que sean localizados en Google. — Pero, ¿Quién o qué es el Googlebot? Googlebot somos todos y no es nadie a la vez (? Bueno, basta de filosofía barata. Vamos con el post.

A los seguidores de George Louis Borges?? «también conocido como bichi Borghi» les voy a pedir que se imaginen La biblioteca de Babel «Una gran biblioteca, la más grande de todo el mundo».

Esa biblioteca además de tener todos los libros que se te puedan ocurrir, es administrada por pequeñas arañas que van de acá para allá clasificando los libros.

Trayendo los nuevos libros a los estantes, y registrando cada uno de los títulos con todos sus capítulos y palabras en un inmenso documento que nunca terminará de construir. Bueno, esto mismo, al igual que en La Biblioteca de Babel, ocurre en los sitios web.

Cada una de estas arañas, o spiders, o crawlers, son gestionadas por un ser superior mejor conocido como Googlebot.

— Ahora vienen las teorías conspirativas. ¿Acaso Borges sabía algo? ¿Acaso Borges era Masón???. ¿Borges estaba en una secta secreta con Lovecraft??? Bueno, todo eso y más lo descubriremos en otro sitio.

Volviendo al post del Googlebot, parece que todo el proceso suena a fantasía, pero está sucediendo ahora mismo en la Web.

Los libros son cada sitio web, los capítulos son las respectivas URLs, y el documento interminable es el índice al que accedes cada vez que realizas una búsqueda en cualquier buscador. Sin más misterio, ¡comencemos con el post!

¿Qué es Googlebot?

Googlebot es el nombre que se le da a estas «spider crawlers». Cada buscador tiene sus propios robots, por lo que los Googlebots son exclusivos de Google, por ejemplo, el nombre del buscador de Bing es AdIdxBot «criatura salida del averno».

El trabajo de estas spiders es rastrear actualizaciones en las páginas existentes y hallar páginas nuevas para clasificarlas e ingresarlas en el índice.

Que nuestras páginas y actualizaciones se registren en dicho índice es el primer paso para construir nuestra visibilidad y posicionamiento en la Web.

Conceptos básicos para comprenderlo

Antes de comenzar, a entender los procesos del Googlebot, necesitamos comprender una terminología básica referente a los buscadores web.

1. Crawling

En inglés, la palabra “crawl” se refiere al movimiento lento con el que se desplazan ciertos insectos. En nuestro contexto, crawling es el proceso realizado por los motores de búsqueda para identificar y clasificar las páginas web.

Así, “crawler” es otra manera de llamar a los robots (lo cual es bastante irónico, pues, las spiders no son lentas).

El crawling se hace de forma periódica para identificar contenidos actualizados, enlaces obsoletos, etc.

2. Indexar

“Index” significa “índice” en inglés. Cada vez que un Googlebot pasa por una página web, la indexa, es decir, la incluye en el índice. Y cada vez que realizas una búsqueda, el buscador va a la parte del índice donde se encuentra esta página y le otorga una posición, la cual depende de un algoritmo.

Para continuar con el ejemplo de La Biblioteca de Babel, podríamos decir que cada vez que se indexa un sitio, se mete un libro al estante.

3. Algoritmo

Hacer una búsqueda es como preguntarle algo al buscador. No necesitas millones de respuestas,solo necesitas una o pocas que te den la información justa. Para eso existen los algoritmos, que determinan el posicionamiento de una página con respecto a una búsqueda específica.

Los más de 200 factores que tiene en cuenta el algoritmo para tomar esa decisión son secretos. Sin embargo, hay técnicas de SEO que ayudan a mejorar el posicionamiento orgánico en los buscadores.

Los algoritmos más importante que debemos conocer son 4: El Hummingbird; el RankBrain; El Panda; y el Pingüino.

4. Pagerank

Es la calificación que Google le otorga a cada página web dependiendo de su relevancia y se realiza en una escala de 0 a 10. Para definir esta calificación, Google mide la cantidad, calidad y contexto de los clics que cada página recibe.

De manera que, si hay enlaces apuntando a tu página provenientes de otras páginas con un alto pagerank, esto le trasladará valor a tu página. Un alto pagerank influye en tu posicionamiento en los resultados de búsqueda.

5. Sitemap

Es el archivo XML que se aloja en el servidor de tu sitio web, y en el que le muestras a los motores de búsqueda las páginas de tu sitio.

También sirve para proporcionar información a Google en forma de metadatos sobre los tipos de contenido incluidos en las páginas, cada cuanto se actualizan, su importancia con relación a otras URL del sitio, etc.

Este documento facilita el rastreo de las páginas por parte de los Googlebots. Lo ideal es siempre subir tu sitemap al Google Search Console.

Por cierto, si les interesa profundizar en este tema, les recomiendo leer sobre el Crawl Budget.

¿Cómo funciona Googlebot?

El proceso de crawling comienza por las direcciones web rastreadas en el pasado y los sitemaps que proveen los desarrolladores. A medida que estos rastreadores pasan por los sitios, usan los links en ellos para descubrir otras páginas. Van saltando de enlace en enlace hasta que se quedan sin, y luego salen del lugar.

La información obtenida les permite identificar nuevos sitios, cambios y enlaces rotos, etc.; y todo eso sirve para actualizar el índice de Google. Cada vez que Googlebot encuentra una página, analiza su contenido, la indexa y la incluye en su ruta para revisarla periódicamente.

La frecuencia con la que este robot pasa por cada página depende de su pagerank «a mayor pagerank, más frecuencia». Además de páginas web (HTML), Googlebot puede indexar archivos PDF, XLS y DOC.

Existen dos tipos de Googlebot:

Freshbot

Es un tipo de rastreador que se especializa en encontrar contenido nuevo, por lo que visita asiduamente los sitios que se actualizan constantemente, como los de noticias.

Deepbot

Se encarga de analizar a profundidad cada página, siguiendo cada uno de sus enlaces, guardando en caché las páginas que encuentra y haciéndolas visibles para el buscador.

Podemos ver lo que Google tiene en la memoria caché. Simplemente, tenemos que buscar la URL que queremos, y hacer clic en la flechita pequeña que se encuentra al lado del sitio.

¿Cómo hago que Googlebot pase por mis páginas?

Si te preguntas, “entonces, ¿cómo hago que Googlebot pase por mis páginas?”, aquí te dejo algunos tips para facilitarle el acceso:

Crea contenidos frescos y de alta calidad «Marketing de contenidos».

Actualiza constantemente «mínimo cada 15 días».

Añade los links a tus redes sociales. Los bots encontrarán tus páginas a través de estos.

Haz linkbuilding «Enlaces internos y externos».

Crea una estructura fluida que permita una fácil navegación por cada página de tu sitio.

Evita el uso de Flash y otras formas de programación no accesibles.

Crea un sitemap. Si tu sitio está hecho en WordPress solo debes instalar uno de los plugins para generarlo. Este debe registrarse en Google Search Console.

Añade tu web a marcadores sociales de calidad como Delicious, Digg o Stumbleupon.

Cuida la calidad técnica de tu sitio: velocidad de carga, diseño responsivo, etc.

Usa robots.txt. Este archivo sirve para bloquear la indexación de las URL que no te interesa indexar.

Para saber cuándo fue la última vez que el Googlebot pasó por tu página, solo accede a la versión en caché. En la parte superior verás la fecha y hora a la que pasó.

Conoce cómo funciona la indexación de contenidos en Google y cómo influye en la presencia digital de las empresas

La indexación es el proceso por el cual Google anexa una página web a su índice para mostrarla en los resultados de una búsqueda.

Luego de estructurar, escribir y cargar contenidos, finalmente tu sitio web está listo para recibir a los innumerables usuarios que navegan en Internet. Sin embargo, cuando escribes el nombre de tu sitio en el buscador este ni siquiera aparece, —¿Te pasó?

A todos nos pasó. Por eso hoy te voy a mostrar la estrategia ganadora para aparecer en Google: la indexación.

¿Por qué es necesario indexar un sitio web en Google?

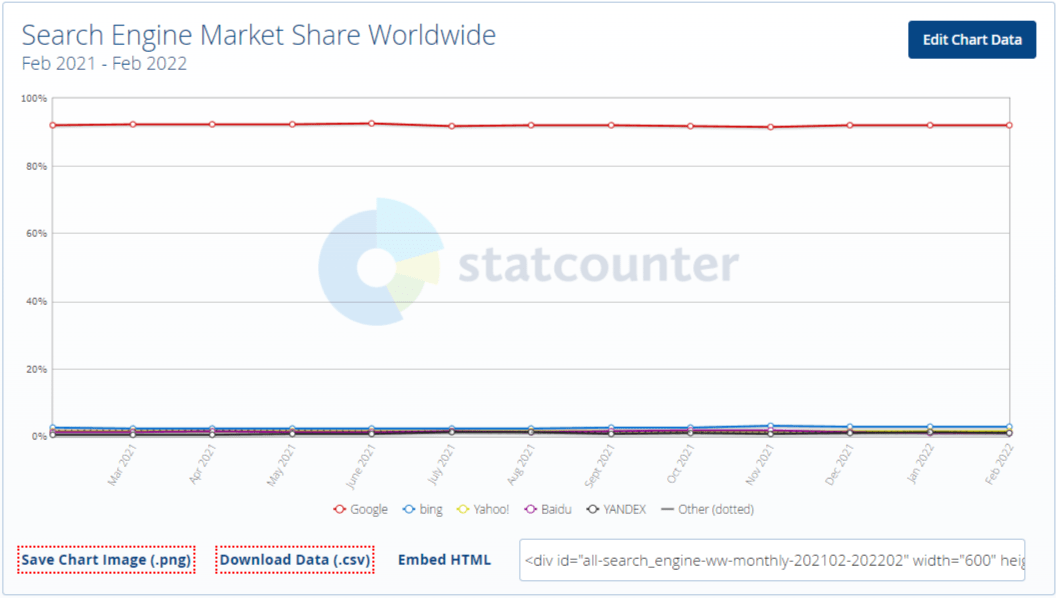

Dado que más del 90% del tráfico de todo Internet está canalizado por Google, se hace necesario estar allí si tienes una estrategia de Marketing Digital. — ¿verdad?

Por medio de la indexación aseguras que tu sitio web aparecerá en los resultados de búsqueda. Sin ella, Google simplemente no sabrá que existes.

Repasemos un poco. Cuando un usuario hace una búsqueda, Google se vale de un gran índice para revisar rápidamente todos los sitios web que contienen información relevante frente a esa búsqueda y mostrarlos en función de su posicionamiento SEO.

Como imaginarás, si tu sitio no está en ese índice, Google no podrá consultarte y por tanto no podrá mostrar tu página como resultado a la búsqueda de un usuario.

Sin usuarios que visiten tu página, nadie verá tu contenido por medios orgánicos y disminuirá la generación de leads y las oportunidades de venta.

¿Cómo funciona la indexación con Googlebot?

— Pero, ¿cómo hace Google para reconocer nuevos sitios web y alimentar su índice? Bueno, el proceso funciona en tres etapas.

1. Rastreo o Crawling

Google, como todo buscador, cuenta con un software rastreador «crawler en inglés» llamado Googlebot que navega permanentemente en la web en busca de nuevas páginas o actualizaciones en las páginas existentes de su índice.

Googlebot descubre nuevas páginas web cuando las encuentra enlazadas a sitios que ya conoce o cuando los desarrolladores le proporcionan información mediante los sitemaps.

2. Indexación

Una vez que descubre las nuevas páginas o las actualizaciones, Google interpreta su contenido, lo clasifica y lo añade a su índice, es decir, lo indexa.

Desde ese momento, la página web está en la gigantesca base de datos de Google, disponible para aparecer cuando un usuario realice una búsqueda de su temática.

— ¡Qué decirte! ¡la magia del Big Data!

3. Publicación y posicionamiento

El paso final ocurre cuando un usuario realiza una búsqueda y Google, mediante sus algoritmos, identifica entre su índice cuál es la respuesta más relevante a su inquietud, sean sitios web, imágenes o videos.

Para mejorar esto, tenés al menos 50 puntos para controlar en un análisis SEO.

7 pasos para indexar una web a Google

Llegó el momento de pasar de la teoría a la práctica. Aquí conocerás cuáles son los pasos que debes seguir para indexar correctamente una página web en Google. ¡Síguelos atentamente!

1. Configura Google Search Console

Google Search Console es una herramienta gratuita de Google que brinda información sobre el estado de indexación de las páginas web. Muestra errores de configuración y datos de analítica web con los que podrás identificar optimizaciones a realizar en tu sitio, por lo que es el primer paso que debes tomar.

También te recomiendo agregar la etiqueta de Google Analytics o la de Google Tag Manager.

2. Crea el sitemap

Un sitemap es, como su nombre indica, un mapa del sitio web que muestra información sobre las páginas y contenidos de un sitio web y sus relaciones. El archivo contiene las URLs de tu sitio web ordenadas jerárquicamente, lo que facilita la labor del Googlebot en el rastreo e indexación.

3. Crea el archivo robots.txt

La función del archivo robots.txt básicamente es indicarle a Googlebot cuáles páginas y contenido debe rastrear e indexar y cuáles no. Se usa para evitar que páginas que no deseas que aparezcan en la SERP se muestren como resultados de una búsqueda.

4. Añade contenido de calidad frecuentemente

Cuando agregas contenido nuevo o actualizas el existente de forma regular, le muestras a Google que realizas cambios en tu sitio constantemente, lo que obligará a Googlebot a rastrear tu página con frecuencia.

Esto es beneficioso para indexar fácilmente contenido nuevo en cuestión de horas o minutos. Para podés hacer un buen contenido tenés dos herramientas principales: El Copywriting y el Marketing de contenidos.

5. Implementa una estrategia de backlinks y link building

Consigue que sitios web que sean reconocidos por Google enlacen a tu página, o enlaza contenidos relevantes de estos sitios en tus propias publicaciones. Los enlaces falsos no son buenos «es como una caja de bombones, nunca sabes lo que te va a tocar».

Sí querés pagar por «algo», podrías usar enlaces patrocinados, pero la apuesta segura es generar backlinks de gran autoridad. Igualmente, si tienes contenido nuevo, enlázalo a otra URL de tu sitio que ya esté indexada y posicionado. Todas estas prácticas de SEO Off page te ayudarán a potenciar tu posicionamiento web.

6. Vigila que no existan enlaces rotos

Si Googlebot detecta que un enlace o una URL de tu sitio web no lleva a ningún lugar se complicará su labor de indexación. Detecta los enlaces rotos y crea redireccionamientos para no comprometer la experiencia del usuario. Si hay enlaces rotos (páginas 404), podés tirar unas redirecciones 301.

7. Optimiza el posicionamiento orgánico de tu web

La indexación es el paso previo al posicionamiento, y uno no tendría sentido sin el otro. Hay que tener un SEO técnico, y un SEO on page optimizado, porque solo así podrás estar en las primeras posiciones y llevarte todo el tráfico.

Tener una página web posicionada mejora tu autoridad de dominio y le muestra a Google que tu contenido aporta valor. Al final, ya sabes que eso le encanta al buscador, y por eso indexará rápidamente y sin problemas todo tu contenido nuevo.

Pros y contras de Googlebot

Como todo en la vida, hay pros y contras dentro de cada herramienta, software, producto, etc. y Googlebot no es la excepción a la regla:

Pros del Googlebot:

- Puedes construir rápidamente una lista de enlaces que vienen de la Web.

- Sigue con frecuencia las páginas populares que más se actualizan.

Contras del Googlebot:

- Sólo sigue enlaces HREFlinks y Dofollow.

- Algunas páginas pueden tardar más en encontrar, por lo que el rastreo puede ocurrir una vez al mes por día.

¿Cómo mejorar el rastreo de Googlebot con el archivo Robots.txt?

Para mejorar el rastreo de Google, este recomienda que use el archivo robots.txt, con él, el administrador o propietario del sitio puede indicar qué es lo que quiere que el buscador rastree y qué no.

En caso de incluirlo en el proceso, podrá indicar cómo quiere que este sea mostrado en los resultados de búsqueda. Es así como se debe indicar a los rastreadores que no muestren cierto contenido en los motores de búsqueda, el atributo name="robots" es para todos los rastreadores.

Si quisieras incluir uno en específico, basta con sustituir el valor «robots» del atributo «name» por el nombre del buscador que deseas excluir. Otras de las novedades que te ofrece Googlebot para personalizar el proceso es que te permite integrar las búsquedas en sus propias páginas.

Esto no es más que agregar un buscador dentro de tu web para que sea el propio usuario quien encuentre contenido relacionado con lo que está buscando.

Es un gran aporte que el rastreo de Google puede darle a los propietarios, debido a que tiene la oportunidad de conocer el comportamiento del usuario una vez que estos resultados sean enlazados a Google Ads, que como sabes es otra herramienta para impulsar el posicionamiento gracias a enlaces patrocinados.

Factores que Googlebot toma en cuenta para posicionar

Google valora unos 200 aspectos para que solo los mejores puedan posicionar sus páginas en los primeros lugares. A parte de los detalles técnicos antes mencionados, también habrá que evaluar si tus páginas o web cumplen con algunos de estos requisitos:

1. La palabra clave en el nombre del dominio

Las palabras clave «Keywords, para la gente bonita» son de los principales factores del SEO on page. Googlebot pasea por tus distintas páginas y el medio para hacerlo es por las URLs, por lo que es de provecho ajustarse a este requerimiento.

2. Antigüedad del dominio

Matt Cutt, quien fue el director del departamento contra Spam en Google, ha declarado que la antigüedad influye directamente con el Pagerank o lo que es lo mismo el Domain Authority, pero no exclusivamente.

3. Domian Authority

La autoridad de dominio es un trabajo lento y parsimonioso, por lo que comprueba que la antigüedad del dominio si puede ser una gran ayuda para ser considerado merecedor de los primeros lugares.

4. Densidad de las palabras clave

Para calcularlo, bastará con usar algún CMS como WordPress, porque uno de sus plugin te indicará cómo va lo de la densidad de la keyword a medida que vas escribiendo.

Esto lo puedes ver aplicar con Yoast en WordPress.

5. Velocidad de carga del sitio o página

Google puede evaluar el rendimiento de tu web o página desde el navegador del usuario para determinar qué tan rápida es el sitio al requerimiento.

6. Actualización de contenido constante

Un requisito que bien puede aportar valor no solo al posicionamiento, sino es un gran motivo para impulsar las visitas de Googlebot.

7. Actualización constante de una página en específico

Perfecto para tener en cuenta a los blogs o en el caso de eCommerce, la creación de un nueva producto con contenido en su ficha.

8. Enlaces de calidad

Esto tiene que ver con los sitios con autoridad que enlazan a tu web. Para conseguirlo, puedes desarrollar técnicas de LinkBuilding o Guest blogging.

9. Número de enlaces internos

Se trata de lo mismo que mencionamos más arriba, pero el tratamiento de enlaces lo harás tú mismo desde tu web para algunas de tus páginas internas. Es cuando en un post enlazas a otro post desde ese contenido.

10. Enlaces rotos

Hay que tener cuidado con la cantidad de enlaces rotos que Google encuentra en tu web. Tantos podrían indicarle que tu web ha sido abandonada, puesto que no se han actualizado estos enlaces.

11. Longitud de las URLs

Una URL tan extensa dificulta la tarea de rastreo, por lo que impide el resto del proceso (indexación y clasificación del contenido en la biblioteca de Google).

12. Cantidad de páginas

En posicionamiento todo cuenta y aunque no es un factor decisivo para ganar las primeras posiciones, es un elemento de valor.

13. La UX y la experiencia de usuario

Este punto guarda relación estrecha con el porcentaje de rebote, si un usuario llega y se va sin perdurar en cualquiera de las páginas, Google lo tomará como que no cuentas con lo que el usuario quiere o busca y te evaluará de forma negativa.

Hasta aquí bien, ya te explicamos cuál es el procedimiento de rastreo de Google.

Ahora te toca cumplir con los requisitos de los buscadores para posicionar y encontrar las herramientas adecuadas que te ayudarán a mejorar los aspectos técnicos y de SEO para tu web.

Cómo mirar su sitio web como lo hace Googlebot

Cuando pasas meses o años en un sitio web, sin mencionar miles de dólares, es difícil dar un paso atrás y mirarlo objetivamente. — ¿Podés mirarlo a través de los ojos de tus usuarios? ¿y verlo como lo hace Google?

Si puede mirar su sitio web como lo hace Google, probablemente descubrirá áreas en las que su sitio web necesita trabajar. Entonces, con ese espíritu, le enseñaré cómo puede ver su sitio web desde la perspectiva de Google, y cómo puede enfocarse en las áreas que necesitan mejorar.

Primero, Googlebot encuentra su sitio web

Para ver su sitio web, Google debe encontrarlo.

Cuando crea un sitio web, Google lo descubrirá eventualmente. El robot de Google rastrea sistemáticamente la web, descubre sitios web, recopila información en esos sitios web e indexa esa información para que se devuelva en la búsqueda.

Puede ayudar al robot de Google con este proceso, y debería hacerlo. Si sigue los pasos a continuación, su sitio se indexará más rápido.

Primero, cree un mapa del sitio : un mapa del sitio es un documento especial creado solo para motores de búsqueda. Si su sitio carece de un mapa del sitio, debe instalar uno. Los usuarios de WordPress pueden instalar Google Sitemap Generator para crear uno de forma fácil pero eficaz. De lo contrario, puede utilizar sitios como xml-sitemaps.com para generar uno. Deberá cargar el archivo del mapa del sitio en su directorio raíz.

Envíe su sitio web a Google search Console: Esta herramienta te ayuda a indexar tu sitio, además de brindarte una gran cantidad de información valiosa. Lo primero es registrarse en Google Search Console. Luego, debemos rastrear e indexar nuestro sitemap, para que éste añada nuestro sitio a los motores de búsqueda.

Último paso: si desea hacer un esfuerzo adicional, podés indexar manualmente las diferentes URL. Este método es más engorroso, pero la indexación es mucho más rápida, pues, le da prioridad a dichas páginas.

Ahora que Google ve su sitio web, debe averiguar qué verán cuando lo vean.

Googlebot no mira nada bloqueado por robots.txt

Su Robots.txt le dice a Google, «puede ver estas secciones de mi sitio, pero no estas otras secciones«.

Si hay archivos, páginas o directorios en su sitio que no están permitidos, Google cumplirá con su solicitud al no indexarlos. Como resultado, estas páginas no se mostrarán en los resultados del motor de búsqueda.

Un archivo robots.txt puede ser tan simple o complicado como desee. Recomiendo un enfoque simple.

Todo lo que necesita es un archivo de texto en su servidor web, titulado robots.txt. Antes de mirar su sitio, verifica qué tiene permiso para rastrear. Cuando Google rastree su sitio, buscará este archivo.

Googlebot mira tu título

Después de verificar su archivo robots.txt, Google busca una pepita de contenido en su sitio web: el título de la página. Es una metaetiqueta, encerrada por <title> en el código HTML de su página.

Así es como Google ve su etiqueta de título:

Google ve tu título H1 completo, pero solo 65 caracteres importan. Esos 65 caracteres son lo que verá un usuario cuando su página aparezca en las páginas de resultados del motor de búsqueda (SERP).

Google ve todos los títulos en todas sus páginas «etiquetas H2 a H6» y quiere que cada uno sea único. No asigne el mismo título a todas las páginas de su sitio.

Google ve las palabras clave en los títulos «etiquetas H1 a H3», pero no quiere ver un relleno de palabras clave «Keyword Stuffing». En otras palabras, su etiqueta de título debe contener más que solo palabras clave.

Googlebot mira tu descripción

Después de mirar su título, Google pasa a la descripción de su página.

La descripción de la página es otra metaetiqueta, esta vez encerrada por la etiqueta <description>.

Aunque Google indexa su meta descripción, no la usa como factor de clasificación. En otras palabras, no obtendrá clasificaciones más altas con un abuso de etiquetas de descripción centrada en palabras clave. Hay una descripción para sus usuarios, y Google mira la descripción para mostrarla a los usuarios en el SERP.

Debe incluir una meta descripción en cada página, reconociendo que Google la mira, pero no depende de ella como un factor de clasificación importante.

Asegúrese de escribir una breve meta descripción para cada página, que tenga aproximadamente 160 caracteres y, lo más importante, debe ser escrita por y para humanos.

— ¡Algo más de lo que te tenés que acordar! Esta descripción es probablemente la única copia publicitaria gratuita que obtiene en todo el planeta. Así que no lo pase por alto. Dedique tiempo a crear descripciones convincentes que aumentarán su tasa de clics.

Googlebot no puede ver cómo se ven sus imágenes, pero mira las etiquetas alt para ver de qué se trata la imagen

Google es bastante bueno para ver casi todo en su sitio.

Pero para su sitio, las etiquetas alt en las imágenes son lo que realmente importa. Esto es lo que Google indexa y utiliza como parte de los resultados de búsqueda. Aunque no necesariamente puede ver la imagen, ve lo que usted proporciona en la etiqueta alt.

Lo que sí puede ver Google de las imagenes, son patrones. Pues, por medio de Google Lens, se pueden relacionar diferentes imágenes, pero le debemos ordenar dicha acción, más el rastreador no lo hace por cuenta propia.

Una etiqueta alt es parte del código HTML de cualquier imagen de su sitio.

<img src = ”http://www.example.com/picture.png” alt = "palabra clave">

La palabra clave en la línea anterior es donde debe proporcionar una breve descripción de su imagen. Cada imagen necesita esto, y debe ser una descripción que esté relacionada con la imagen real.

En algunos CMS, las etiquetas alt se generan automáticamente. A veces, los aplica indiscriminadamente alguien que no conoce las prácticas adecuadas de etiquetado alternativo.

En su lugar, debe crear etiquetas alt para imágenes que sean descriptivas, inteligentes con palabras clave y útiles. Para asegurarse de tener etiquetas alt, simplemente mire su código HTML para ver si hay información después de alt = para cada imagen.

Es posible que desee comprobar su archivo robots.txt para asegurarse de que no está impidiendo que se rastreen imágenes en el sitio. Una vez que tenga todas las imágenes bien etiquetadas con alt, siga adelante y deje que los rastreadores se suelten en esta valiosa fuente de potencial de rango.

Googlebot mira el contenido

Bueno, muy lindo todo. Pero, antes de desarrollar uno de los tres factores SEO más importantes, debemos entender cuales son éstos. El primero es el SEO on page, luego tenemos el SEO off page, y finalmente tenemos el Contenido SEO.

El Contenido es posiblemente, a día de hoy, el factor más relevante para el posicionamiento. Luego, sí el Googlebot se encuentra dos sitios con un contenido similar, el robot se fija cual tiene mejor SEO on page. Pero, sí llegado al caso de que estos parámetros estén optimizados, luego se mira el SEO off page.

Eso si, cuando se habla de contenido, me refiero básicamente a todo lo que no está restringido por el código HTML y que se muestra a los usuarios en todo su esplendor glorioso, sin dejarse intimidar por los requisitos de longitud y libre para transmitir información poderosa, convincente y útil.

Google ve e indexa cada palabra de su página . Y cuanto más contenido tenga, mejor. Google no está limitado en la cantidad de páginas de su sitio web que rastreará, indexará y devolverá. Llega a todo .

Te recomiendo que tengas mucho contenido en cada página . No puedes equivocarte con mucho contenido. Pero, por favor, asegúrese de que sea contenido de calidad.

Google no solo mira todo su contenido, sino que también hace que sus robots de Google se vuelvan locos cada vez que publique contenido nuevo. Por eso insisto en producir contenido épico todas las semanas y por eso te sugiero que hagas lo mismo.

El factor novedoso de Google sugiere que el contenido regular, nuevo e impresionante obtendrá el aspecto de Google.

Conclusión:

Conocer el funcionamiento de los buscadores y la función de Googlebot es importante para saber cómo posicionar mejor nuestro contenido. La clave más importante es pensar siempre en el usuario, brindándole facilidad y valor en todos los aspectos: desde los contenidos hasta la navegación

Dar una nueva mirada a su sitio web desde la perspectiva de Google le ayuda a salir de la rutina de obsesionarse con las mismas cosas viejas en su sitio.

Es probable que Google se preocupe por algunos factores que son diferentes de lo que sigue viendo. Lo que he enumerado anteriormente son los más importantes de esos factores.

— ¿Por qué no te tomas unos minutos con tu sitio web, repasando cada uno de estos factores? Vea si puede echar un vistazo a lo que está viendo Google. Realmente podrías mejorar tu clasificación.

Ahora si, para finalizar, quiero dejarte un regalo de 25 dólares para que puedas crear tu próximo sitio web en WordPress. Luego de crearlo, podrás hacer que el bueno del Googlebot te indexe.

FAQs sobre el Googlebot:

¿Qué es Googlebot?

Googlebot es el nombre que se le da a estas “spider crawlers”. Cada buscador tiene sus propios robots, por lo que los Googlebots son exclusivos de Google, por ejemplo, el nombre del buscador de Bing es AdIdxBot «criatura salida del averno».

¿Cómo funciona Googlebot?

El proceso de crawling comienza por las direcciones web rastreadas en el pasado y los sitemaps que proveen los desarrolladores. A medida que estos rastreadores pasan por los sitios, usan los links en ellos para descubrir otras páginas. Van saltando de enlace en enlace hasta que se quedan sin, y luego salen del lugar.

oye, increible todo lo que escribiste.

Me encanto.

Gracias por compartir.